|

|

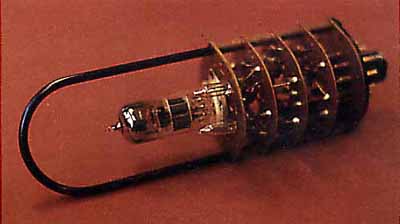

Flip-Flop-Röhre eines Rechners aus dem Jahr 1956. Inzwischen verwendet man für Flip-Flop-Schaltungen längst Transistoren. |

Der DDR-Rechner PRL ging nie in Serie, da seine Röhrentechnik schon bei der Fertigstellung 1959 überholt war. |

|

|

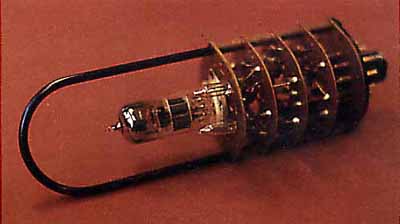

Flip-Flop-Röhre eines Rechners aus dem Jahr 1956. Inzwischen verwendet man für Flip-Flop-Schaltungen längst Transistoren. |

Der DDR-Rechner PRL ging nie in Serie, da seine Röhrentechnik schon bei der Fertigstellung 1959 überholt war. |

Computer können buchstäblich nur bis zwei zählen, was bei einem Menschen als Schwachsinn gelten würde. Auch ihre Rechenkünste sind eigentlich sehr bescheiden: Sie beschränken sich auf das Addieren. Alle sonstigen Rechenarten wie Subtrahieren, Multiplizieren und Dividieren erledigen Computer auf der Basis der Addition.

Daß ein Computer nur bis zwei zählen kann, liegt daran, daß er nur die Zustände "Strom ein" und "Strom aus" kennt. Auf der Umsetzung dieser beiden Schaltzustände in die Zahlen 1 und 0 basiert letzten Endes alles, was der Computer auf dem Bildschirm zaubert: Von Rechenoperationen über Texte, Bilder und Töne bis hin zu Videos.

Mittels sehr einfach aufgebauter Schaltungen setzt der Computer diese beiden möglichen Zustände in die logischen Funktionen UND, ODER und NICHT um. Die "Elektronengehirne", wie man die ersten Computer ehrfürchtig nannte, gleichen deshalb eher komplizierten Lichtschaltern als einem menschlichen Gehirn.

Die logische Operation UND wird durch zwei Schalter

bewerkstelligt, die in Serie bzw. hintereinander geschaltet sind:

|

Ähnlich simpel wird die logische Operation

ODER durch Parallelschaltung erzeugt:

|

Die NICHT-Schaltung ist ebenfalls sehr einfach: Sie besteht aus einem Schalter, der bei Stromfluß einen Kontakt öffnet und damit einen Sekundärstromkreis unterbricht. Der normale Schaltvorgang wird also umgekehrt, wie das z.B. bei einem Relais mit Ruhestromkontakt der Fall ist.

Diesen drei Schaltungen entsprechen die "Konjunktion", die "Disjunktion" und die "Negation", wie sie der englische Mathematiker George Boole vor über hundert Jahren in seiner "Algebra der Logik" entwickelte. Die Boolsche Algebra ist das theoretische Fundament aller elektronischen Rechner. Sie kennt nur die die Elemente "wahr" und "nicht wahr", wofür ebenso "Strom ein" und "Strom aus" stehen kann. Mittels der Boolschen Algebra lassen sich deshalb selbst die kompliziertesten logischen Operationen in die Sprache des Computers übersetzen. Man braucht sie nur in entsprechend viele Einzelschritte zu unterteilen, die der Computer dann sukzessive abarbeitet.

Bei den allerersten Computern bedeutete "Strom ein" tatsächlich noch, daß ein elektromagnetisch betätigter Schalter (Relais) einen Schaltkontakt schloß oder öffnete. Es klickte und klackerte also mächtig, wenn der Computer rechnete. Geräuschloser wurden die Computer erst mit den elektronischen Schaltelementen: Das waren zunächst Röhren, bei denen die am "Gitter" anliegende Spannung den Stromfluß zwischen Kathode und Anode sperrte oder freigab. Aber auch die Röhren-Computer waren noch riesige Apparate mit vergleichsweise geringen Rechenleistungen. Als die Firma IBM 1948 ihren ersten Rechner herausbrachte, enthielt er 12 500 Röhren und 21 400 Relais. Und alle paar Minuten gab eines der unzähligen Schaltelemente den Geist auf...

Der weltweite Siegeszug der elektronischen Rechner konnte deshalb erst beginnen, nachdem man die Röhren durch die neu erfundenen Transistoren ersetzt hatte: Diese elektronischen Schalt- und Verstärkungselemente verbrauchen fast keinen Strom und sind enorm betriebssicher. Vor allem lassen sie sich in ungeheuerlich großer Zahl auf einem Halbleiter-Chip von Fingernagelgröße unterbringen.

Freilich hat man noch keinen Computer, wenn man die drei logischen Grundschaltungen zweckentsprechend kombiniert und in großer Zahl auf einem Chip unterbringt. Man erhält dann nur eine festverdrahtete logische Schaltung, die als Transistor-Transistor-Logik (TTL) bezeichnet wird. TTL-Schaltungen findet man beispielsweise in den sicherheitsempfindlichen Bereichen der deutschen Kernkraftwerke. Da derartige Schaltkreise keine Datumsfunktionen enthalten, sind sie gegen den Millennium Bug gefeit.

Beim Computer besteht die festverdrahtete Logik (Hardware) prinzipiell aus vier Teilsystemen: Steuerwerk, Rechenwerk, Arbeitsspeicher, Ein- und Ausgabesteuerung. Zusammen ergibt das die Zentraleinheit (CPU). Hinzu kommt eine nicht-verdrahtete Logik, welche die Hardware in unterschiedlicher Weise ansteuert und als Software bezeichnet wird (Betriebssystem, Anwenderprogramme). Diese Software bringt die festverdrahtete Logik des Computers gewissermaßen zum Tanzen. Den Takt schlägt dabei ein Quarz, der pro Sekunde viele Millionen von Schwingungen vollführt. Bei jedem Takt vollführt die Hardware des Computers einen weiteren Arbeitsschritt, den das Programm vorgibt.

Der Ärger mit dem Jahr-2000-Problem rührte bekanntlich daher, daß die Programmierer bei der Jahreszahl zwei Dezimalstellen einsparen wollten. So der oberflächliche Eindruck. In Wirklichkeit rechnet der Computer aber nicht mit Dezimalzahlen. Das liegt ebenfalls an seiner Schaltungslogik, die nur die beiden Zustände "Strom ein" - "Strom aus" kennt. Eine Dezimalzahl kann von ihm erst dann gelesen und verarbeitet werden, wenn sie ihm in binärer, d.h. zweiwertiger Form präsentiert wird.

Zum Glück hat der Philosoph und Mathematiker Leibniz schon 1679 ein Verfahren entdeckt, um jede Dezimalzahl nur mit den Ziffern 1 und 0 darzustellen. Praktischen Nutzen hatte diese Schreibweise vorerst nicht. Für Leibniz symbolisierte sie Gott und das Nichts.

Diese binäre Schreibweise von Zahlen wird als Dualsystem bezeichnet. So wie im Dezimalsystem jede Stelle nach links eine höhere Potenz der Zahl 10 bedeutet (1,10,100, 1000 usw.), so bedeutet beim Dualsystem jede Stelle nach links eine höhere Potenz der Zahl 2 (1, 2, 4, 8, 16, 32 usw.). Um der Verwechslung mit Dezimalzahlen vorzubeugen, wird anstelle der Ziffer 1 häufig ein L verwendet.

Konkret sieht das so aus, daß aus der Dezimalzahl zwei in dualer Schreibweise 10 wird (bzw. L0, um Verwechslungen mit der Dezimalzahl zehn auszuschließen). Die Dezimalzahl zehn wird in dualer Schreibweise zu 1010, und aus hundert wird 1100100.

Wie man sieht, sind Dualzahlen um einiges länger als Dezimalzahlen. Schreibt man die Jahreszahl 1999 computergerecht als Dualzahl, so braucht man dafür immerhin elf Stellen (11111001111). Verkürzt man sie auf 99, kommt man dagegen mit sieben Stellen aus (1100011). Die Programmierer sparten also vier Stellen im Dualsystem, wenn sie die Jahreszahl im Datum um zwei Dezimalstellen verkürzten.

In der Praxis war der Einsparungsgewinn noch größer. In der Computertechnik werden nämlich jeweils acht Bits - das sind die kleinsten Informationseinheiten, die der 1 oder 0 im Dualsystem entsprechen - zu einem "Byte" zusammengepackt. Die zusammengehörigen acht Bits eines Bytes ergeben 2 hoch 8 verschiedene Kombinationsmöglichkeiten. Das sind 256 verschiedene Bitmuster - genug, um alle möglichen Zahlen, Buchstaben und sonstigen Zeichen nur mit den beiden Werten 1 und 0 darzustellen.

Durch Verkürzung der Jahreszahl im Datum sparten die Programmierer also ein ganzes Byte aus acht Bits ein, da sie insgesamt zwölf Bits zur Darstellung der kompletten Jahreszahl benötigt hätten.

Ob diese Knausrigkeit sinnvoll war, muß heute

allerdings mehr denn je bezweifelt werden.

|

|